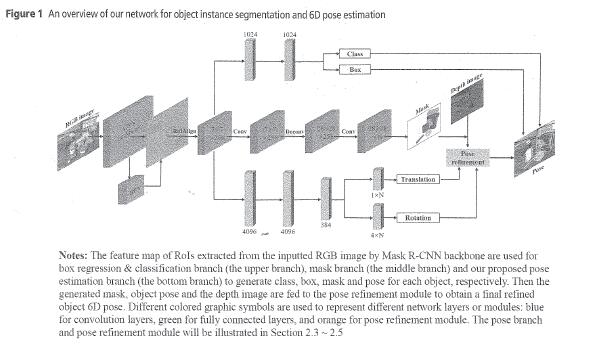

本文旨在设计一种适用于复杂场景中物体实例分割和六维姿态估计的深度神经网络,并将该方法应用于实际机器人对家居物体的自主抓取。本研究提出了一种新的深度学习方法,用于复杂场景中的实例分割和6D姿态估计。将迭代式位姿优化网络与主网络相结合,得到更为鲁棒的机器人最终位姿估计结果。为了训练该网络,提出了一种无需任何人工标注即可快速生成由RGB-D图像和目标掩模组成的大量带注释的合成数据的方法。本文针对机器人抓取问题,提出了一种基于特征抓取规划器的离线抓取规划方法,并与在线目标姿态估计相结合。在标准位姿基准数据集上的实验表明,该方法比基于深度的ICP细化的最新方法具有更好的位姿估计和时间效率。在七自由度Kinova-Jaco机器人上,采用Intel Realsense RGB-D摄像机对该方法进行了实验,实验结果表明,该方法具有足够的精度和鲁棒性,适合于实际机器人应用。