激光雷达的一个缺点是其3D数据庞大且计算量大。例如,典型的64通道传感器每秒可产生超过200万个点。由于额外的空间尺寸,最新的3D模型与2D图像对应物相比,在推理时需要14倍的计算量。这意味着,为了有效导航,工程师通常首先必须将数据折叠为2D格式。这样做的副作用是,它会导致大量信息丢失。

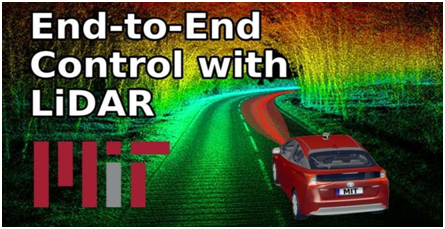

但是麻省理工学院的研究团队一直在研究使用机器学习的自动驾驶系统,因此不需要自定义手动调整。他们的新端到端框架可以仅使用原始3D点云数据和低分辨率GPS地图进行自主导航。

从原始激光雷达数据进行端到端学习是一个计算密集型过程,因为它涉及为计算机提供大量丰富的感官信息,以学习如何操纵。因此,团队必须实际设计新的深度学习组件,这些组件必须更有效地利用现代GPU硬件,以便实时控制车辆。

研究人员从算法和系统角度优化了解决方案,与现有3D激光雷达方法相比,实现了大约9倍的累计加速。在测试中,研究人员表明,他们的系统减少了驾驶员不得不从机器上接管控制的频率,甚至可以承受严重的传感器故障。

例如,想象自己开车穿过隧道,然后出现在阳光下–瞬间,由于眩光,眼睛的视线可能会出现问题。自动驾驶汽车中的摄像头以及天气条件较差时系统的激光雷达传感器也会出现类似的问题。

为了解决这个问题,麻省理工学院的团队的系统可以估计它对任何给定预测的确定性,因此可以在做出决策时或多或少地赋予该预测权重。(在从隧道中出现的情况下,由于传感器数据不准确,它实际上将忽略任何不应信任的预测。)

该团队称他们的方法为“混合证据融合”,因为它将不同的控制预测融合在一起以得出其运动计划选择。

研究人员表示:“通过根据模型的不确定性融合控制预测,该系统可以适应突发事件。”从许多方面来看,该系统本身是以前的三个MIT项目的融合。下一步,该团队计划继续扩展其系统,以增加现实世界中的复杂性,包括不利的天气条件以及与其他车辆的动态交互。